Примечание: Компания Meta признана экстремистской и запрещена в России.

С 2023 года нейросеть от Meta — Llama — стала основой множества прикладных решений в образовании, медицине и бизнесе, а открытые нейросети от Meta, такие как LLaMa 2, 3 и 4, были доступны для доработки под конкретные задачи.

Реальные кейсы интеграции включают:

Прикладные продукты на базе LLama доказали свою ценность за счет гибкости и экономии лицензирования:

Однако стратегический фокус Meta меняется: компания осторожнее относится к раскрытию новых весов, что затрагивает как разработчиков на LLama, так и корпоративных клиентов, строящих собственные продукты на основе этих моделей. В этой статье рассказываем, чего ожидать от новой стратегии компании.

Сегодня Meta AI занимается не только развитием цифровых ассистентов, генерации контента и автоматизации бизнеса, но и интеграцией искусственного интеллекта в пользовательские устройства — например, умные очки с функцией постоянного взаимодействия. Открытые модели линии Llama стали фундаментом для множества решений в сферах образования, медицины, научных исследований и автоматизации рутинных задач.

Многие компании построили собственные сервисы на базе открытых версий Llama. Среди них:

Благодаря публично доступным весам, многие стартапы и ИТ-команды могли минимизировать издержки на внедрение AI и тестировать продукты до масштабирования.

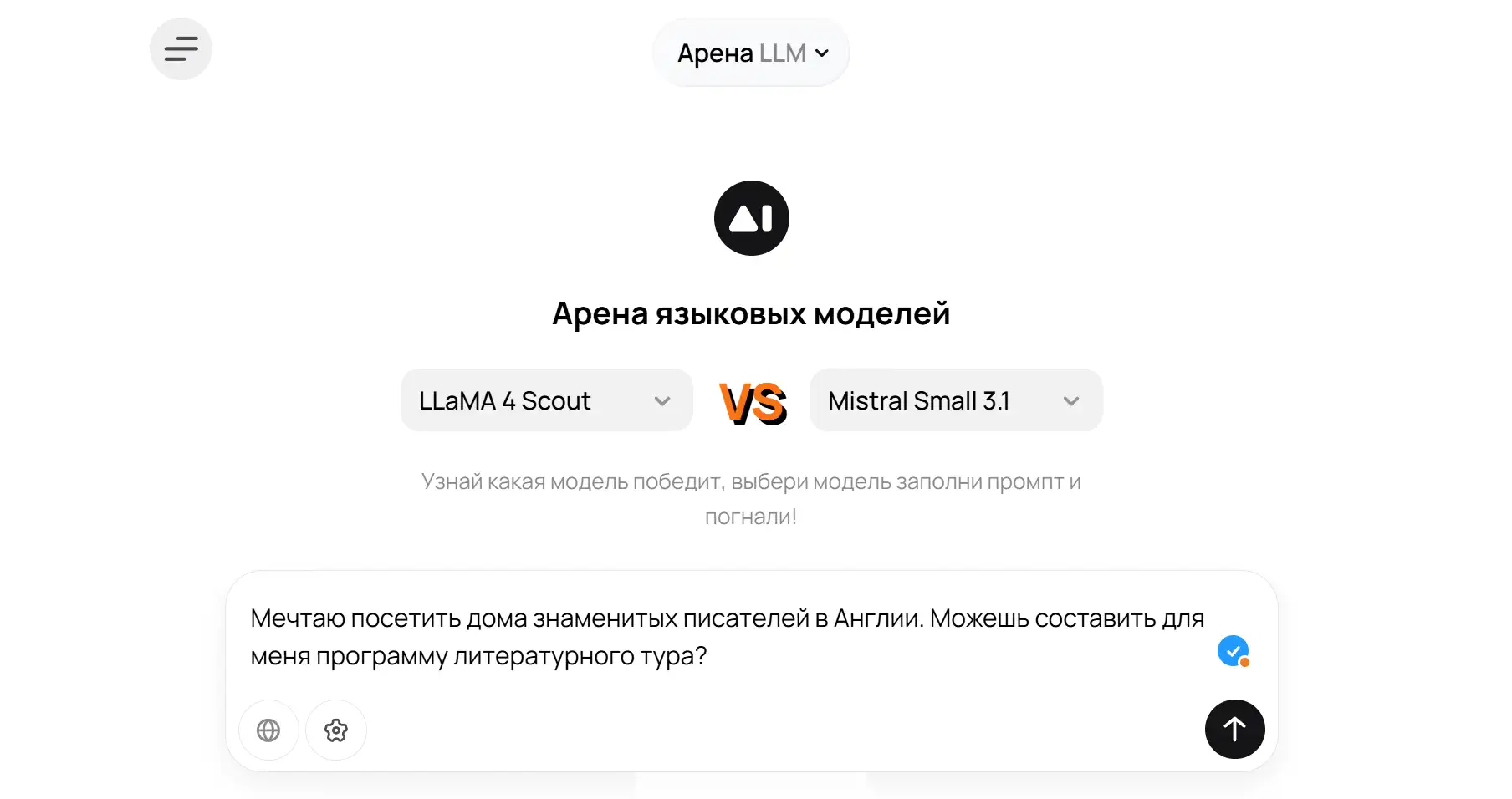

В то же время Meta инвестирует в развитие мультимодальных систем, интегрирующих текст, изображения и аудиовходы, что позволяет создавать ассистентов нового поколения для сложных взаимодействий. Пример работы с разными моделями можно увидеть на Арена LLM от GPTunneL: пользователи сравнивают отклики моделей в реальных задачах и выбирают лучшие решения для конкретного бизнеса.

Два года Meta последовательно декларировала преимущество открытого кода для развития AI, прямо отмечая:

«Открытый исходный код необходим для позитивного будущего искусственного интеллекта... Open source позволит равномерно и безопасно распространить технологию по всему обществу» (источник).

Однако к лету 2025 года политика трансформируется: вместо повальной открытости появляются слухи о гибридном подходе, при котором не все новые модели Llama будут доступны полностью или лицензируются для свободного применения.

В недавнем письме Марка Цукерберга отмечается: Meta концентрируется на развитии «персонального суперинтеллекта» — систем, которые будут:

Однако вместе с этим в письме подчеркивается важность осторожности: по мнению главы Meta, открытость должна уравновешиваться ответственностью, контролем и управлением рисками.

Подобная смешанная стратегия уже становится стандартом для других крупных игроков рынка AI — на смену прежней эволюции open source приходит сегментированный подход, когда лучшие модели защищают от неконтролируемого распространения, опасаясь и рыночной монополии конкурентов, и угроз со стороны плохо регулируемых AI систем.

Всё больше компаний и разработчиков сталкиваются с ограничениями новых моделей по лицензиям или закрытостью весов. Это создает угрозу технического долга — сложностей с обновлениями, миграциями, встроенными зависимостями и долгосрочной поддержкой продуктов, основанных на старых версиях Llama.

Вот, что следует учитывать:

Показательно и то, что моделям стало сложнее поддерживать высокий темп инноваций: пользователи и профессиональные сообщества неоднократно критиковали Llama 4 Maverick за уступающие результаты конкурентам (источник: дискуссии о бенчмарках).

И действительно, в проведенном Artificial Analysis тестировании MMLU-Pro, которое тестирует способности модели рассуждать на общие и профессиональные темы, модель LLaMa 4 Scout со 109 миллиардов параметров остается на одном уровне с намного более компактной и экономичной Magistral Small (24 миллиарда) — 75% правильно выполненных задач. Другой ее конкурент, DeepSeek R1, и вовсе занимает первое место с показателем 85%.

В других бенчмарках, например Humanity's Last Exam или GPQA Diamond, доступных по указанной выше ссылке, наблюдается похожая картина: LLama 4, несмотря на огромный размер, уступает конкурентам или остается на одном уровне при большем размере. Вероятно, это может лишь усилить решение руководства Meta закрывать свои модели и использовать максимум ресурсов на их обучение и работу.

С другой стороны, чрезмерная открытость моделей несет блокирующие риски:

Например, открытые LLM могут нарушать авторские права, получать некорректные данные для обучения или использоваться в обход регуляторных норм. Как результат — корпоративные клиенты предпочитают решения с четкой поддержкой, логами изменений и прозрачной дорожной картой.

Именно эти этческие и юридические аргументы, а не только конкуренция, формируют тренд ограничения открытых весов. Для узкоспециализированных и доверенных решений на первый план выходит качество поддержки и прозрачность лицензирования.

В выигрыше оказываются альтернативные open-source проекты: Mistral, Qwen и DeepSeek продолжают выкладывать модели и коды в открытый доступ, укрепляют свое сообщество и снижают барьеры для внедрения. Недавно даже OpenAI выпустили свои собственные открытые модели.

В итоге, компании теперь вынуждены вкладываться в развитие собственной экспертизы и локальному внедрению моделей в свою инфраструктуру, чтобы не завязнуть на ограничениях одного крупного вендора.

Организации и команда разработчиков должны внимательно анализировать лицензионные условия новых моделей. Уже сейчас есть вероятность, что новые версии Llama будут недоступны для свободного коммерческого применения. Критически важно отслеживать изменения — иначе можно столкнуться с невозможностью поддержки или обновления продукта.

Сравнение с альтернативами показывает, что проекты DeepSeek R1 или GPT-OSS-120B по ряду задач демонстрируют схожие или превосходящие результаты по общим и специализированным бенчмаркам:

Для трезвой оценки альтернатив необходимо последовательно тестировать:

Практическая рекомендация — максимально использовать сравнительное тестирование в реальных рабочих задачах. Это можно сделать через чат с конкретной моделью на Llama 4 Maverick, DeepSeek R1, Qwen 3 235B, а также на Арене LLM, где можно выбрать пару моделей и посмотреть, как они ответят на ваш промпт..

Полностью открытая эпоха крупных языковых моделей постепенно уходит: смешанные стратегии Meta становятся реакцией на вызовы безопасности и технологической конкуренции. Для бизнеса и разработчиков настал период гибридных и резервных стратегий внедрения AI, когда они ищут альтернативы. Meta по-прежнему играет значимую роль на open source рынке, однако делает ставку на многоуровневую и более контролируемую открытость.

Эта трансформация — шанс для инноваторов:

Самое важное — гибкость архитектур и способность быстро адаптироваться к меняющемуся рынку.

Для компаний, которым требуется полный контроль и внедрение AI в изолированной среде, GPTunneL предлагает отдельное решение для бизнеса — локальное развертывание открытых моделей на собственных серверах. Это обеспечивает гибкость, безопасность и соблюдение внутренних стандартов управления данными.